امروزه رهبران سازمانهای پیشرو در حوزه کسبوکار تصمیمی را نمیگیرند مگر آنکه شواهد کافی در تائید آن تصمیم وجود داشته باشد. آزمایش کردن در کسبوکار یکی از روشهایی است که به مدیران کمک میکند تا مبتنی بر داده تصمیم بگیرند و ریسک تصمیمات خود را کاهش دهند.

آزمون A/B یا معادل انگلیسی آن A/B Testing که عمدتاً بهصورت آنلاین کاربرد دارد، یکی از روشهای آزمایش کردن در کسبوکار است. اگرچه امروزه آزمون A/B در طراحی وبسایتها، ابزارکهای تلفن همراه و سایر سامانههای آنلاین کاربرد زیادی دارد، ولی ریشه آن به کارهای دونالد فیشر (Ronald Fisher) آماردان انگلیسی در ابتدای قرن بیستم و مفهوم آزمایش کنترلشده تصادفی برمیگردد. فیشر به دنبال این بود تا کارایی کودهای کشاورزی را ارزیابی کند؛ کود الف موجب افزایش بهرهوری بیشتر میشود یا کود ب. در “مقاله آزمایش کنترلشده تصادفی چیست و چه کاربردهایی دارد؟” بهطور مفصل دراینباره توضیح دادم. در دهه ۱۹۷۰ بهتدریج این مفهوم وارد دنیای بازاریابی شد. برای مثال بازاریابان میخواستند بدانند که ارسال کارتپستال مخاطب را بیشتر به خرید ترغیب میکند یا نامه.

آزمون A/B حالتی از آزمایش کنترلشده تصادفی است که باهدف بررسی کارایی دو نسخه مختلف یک محصول اجرا میشود و معمولاً برای کسبوکارهای آنلاین مورداستفاده قرار میگیرد.

روش انجام آزمون A/B

برای انجام این آزمون ابتدا باید تصمیم بگیرید چه چیزی را میخواهید مقایسه کنید. فرض کنید مطابق شکل-۱ دو نسخه از یک صفحه وبسایت که در آن به تبلیغ محصول جدید خود پرداختید، ایجاد کردید. این دو نسخه در همه موارد بهجز تیتر تبلیغاتی بالای صفحه یکسان هستند. شما میخواهید بدانید این تغییر چگونه بر روی نرخ تبدیل (Conversion Rate – نرخ تبدیل در این مثال میتواند نسبت خرید محصول به تعداد بازدید از آن صفحه تعریف شود) اثر میگذارد. برای این منظور مخاطبان را به شکل تصادفی به دو گروه تقسیم میکنید و هر یک از این دو گروه مخاطب را در معرض یکی از این دو نسخه قرار میدهید. در نهایت بر اساس سنجه تعریفشده، در این مثال نرخ تبدیل، میزان موفقیت هر یک از دو نسخه را مقایسه میکنید.

در حالت ایدئال باید همهچیز برای این دو گروه مخاطب یکسان و تنها تیتر مذکور متفاوت باشد. ولی در دنیای واقعی این کار دشوار است. برای مثال ممکن است برخی از مخاطبان بر روی تلفن همراه خود این دو نسخه را ببینند و طول زیاد یکی از تیترها باعث شود در صفحه تلفن همراه بهراحتی خوانده نشود و روی مقایسه اثر بگذارد. در اینجاست که مفهوم تخصیص تصادفی اهمیت مییابد. با اختصاص تصادفی مخاطبان به دو گروه، احتمال اینکه اثرهای دیگر بهجز اثر موردنظر، نتیجه را تحت تأثیر قرار دهد، کاهش مییابد. در اینجا اثر اصلی موردمطالعه، اثر نسخههای مختلف تیتر تبلیغاتی است. اثر جانبی ناخواسته این است که تیترها در دستگاههای مختلف مانند تلفن همراه یا کامپیوتر چقدر خوب دیده شود.

در برخی موارد ممکن است متغیرهایی که تحت کنترل نیست، اثر قدرتمندی روی سنجه بگذارند. برای مثال فرض کنید مخاطبانی که از تلفن همراه استفاده میکنند در کل تمایل کمتری دارند پس از مشاهده صفحه تبلیغاتی، خریدی انجام دهند. حال اگر پس از تخصیص تصادفی در یک گروه تعداد کسانی که آن صفحه تبلیغاتی را در تلفن همراه خود دیدهاند از گروه دیگر بیشتر باشد، نرخ تبدیل این دو گروه تحت تأثیر فاکتوری خارج از کنترل قرار میگیرد. برای بررسی این موضوع تحلیلگر باید ابتدا دادهها را بر اساس نوع دستگاه کاربران بررسی کند و سپس با در نظر گرفتن نتایج به تحلیل اثر تیتر تبلیغاتی بپردازد (به مفهوم بلوکبندی (Blocking) در آمار مراجعه کنید).

امروزه از آزمون A/B برای ارزیابی رفتار مخاطبان در مواجهه با انواع بنر تبلیغاتی، تیتر، ساختار قیمتگذاری، مدتزمان استفاده رایگان از یک محصول یا خدمت، پیشنهادهای تخفیف، ارسال رایگان یا پولی محصول و سایر موارد استفاده میشود. آزمون A/B میتواند حتی برای بررسی اثر تغییرهای بهظاهر بسیار کوچک بکار برود. برای مثال، شکل-۲ یک تبلیغ ترویجی آنلاین را نشان میدهد که در آن دو تبلیغ تنها در یک کلمه باهم تفاوت دارند. در یکی از آنها اشاره شده است شما میتوانید برای یک دوره آزمایشی ۷ روزه خدمات شرکت را رایگان تجربه کنید. در دیگری دوره آزمایشی، برای ۳۰ روز تعیین شده است. بااینکه ممکن است عجیب به نظر برسد ولی همین تفاوت کوچک تفاوت زیادی در رفتار مشتریان بالقوه ایجاد میکند.

چگونه باید نتایج آزمون A/B را تفسیر کرد؟

دادههای حاصل از آزمون A/B باید بر اساس معنیداری آماری (Statistical Significance) تحلیل شوند. به زبان ساده معنیداری آماری کمک میکند تا مطمئن شویم تفاوت بین دو نسخه صرفاً بر اساس تصادف به وجود نیامده است و تفاوت مشخصی در کارایی دو نسخه وجود دارد.

در مثال شکل-۱، نمیتوان صرفاً بر این اساس که نسخه A دارای نرخ تبدیل بزرگتری است نتیجه گرفت، عملکرد بهتری داشته است. بلکه باید دید بین نرخ تبدیل این دو نسخه تفاوت معنیدار آماری وجود دارد یا خیر. سطح معنیداری آماری منعکسکننده میزان اعتماد شما به نتایج و میزان ریسکی است که میخواهید تحمل کنید. معمولاً سطح معنیداری آماری ۹۵ درصد و یا حاشیه خطا (α) ۵ درصد در نظر گرفته میشود. مفهومش این است که شما با احتمال ۹۵ درصد میتوانید مطمئن باشید که نتایج بهدستآمده بر اساس تصادف حاصل نشده است. برای آشنایی بیشتر با این مفهوم، مقاله “معنیداری آماری به زبان ساده” را بخوانید.

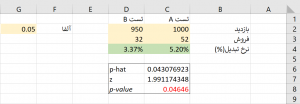

برای این منظور باید از آزمون آماری استفاده کرد. در مثال شکل-۱ چون به دنبال مقایسه نرخ تبدیل دو گروه هستیم، از آزمون تقریبی مقایسه نسبت (Test of Proportions) میتوان استفاده کرد. من در اینجا وارد جزئیات آماری این آزمون نمیشوم. برای راحتی کار خوانندگان، فایل اکسلی را آماده کردم که شما با واردکردن اعداد خود بهراحتی میتوانید این مقایسه را صورت دهید.

دریافت فایل اکسل: A-B Test

فرض کنید در مدتزمان انجام آزمون، ۱۰۰۰ نفر نسخه A و ۹۵۰ نفر نسخه B را بازدید کردند. از میان گروه اول ۵۲ نفر و از میان گروه دوم ۳۲ نفر از آن صفحه خرید کردند. فایل اکسل بهطور خودکار نرخ تبدیل را برای هر دو گروه محاسبه میکند. برای این آزمون حاشیه خطا (α) معادل ۵ درصد در نظر گرفته شده است (شکل-۳).

این فایل اکسل بهطور خودکار مقدار p-value را محاسبه میکند. این مقدار نشان میدهد با چه احتمالی ممکن است بین این دو نرخ تبدیل تفاوت معنیداری وجود نداشته باشد. برای این مثال مقدار مذکور ۰٫۰۴۶ و کمتر از حاشیه خطا ۵ درصد است. بهاینترتیب میتوانیم بگوییم با احتمال ۹۵ درصد نسخه A نرخ تبدیل بهتری نسبت به نسخه B دارد. اگر مقدار p-value بالای ۵ درصد بود، نمیتوانستیم ادعا کنیم بین کارایی این دو نسخه تفاوت معنیداری وجود دارد.

امروزه کسبوکارهای آنلاین پیشرو در دنیا بهطور پیوسته از آزمون A/B برای بهبود وبسایت و سامانههای فروش خود استفاده میکنند. آنان هزاران آزمایش انجام میدهند تا جزئیات مختلف وبسایت خود را بازطراحی کنند، سیاستهای قیمتگذاری را بهبود و تجربه کاربری (User Experience) مشتریان را ارتقاء دهند. آزمون A/B به آنان کمک میکند تا در فضای کنترلشدهای ریسک کنند، نتایج را بر اساس داده ارزیابی و تصمیمات خود را مبتنی بر شواهد اتخاذ کنند.

منابع:

Gallo, A. (2016). “A Refresher on A/B Testing”, Harvard Business Review, https://hbr.org/2017/06/a-refresher-on-ab-testing

Kohavi, R. & Thomke, S. (2017). “The Surprising Power of Online Experiments”, Harvard Business Review, September 2017, 74-82